多种网盘链接检测插件 购买前,请先检测网盘链接是否有效

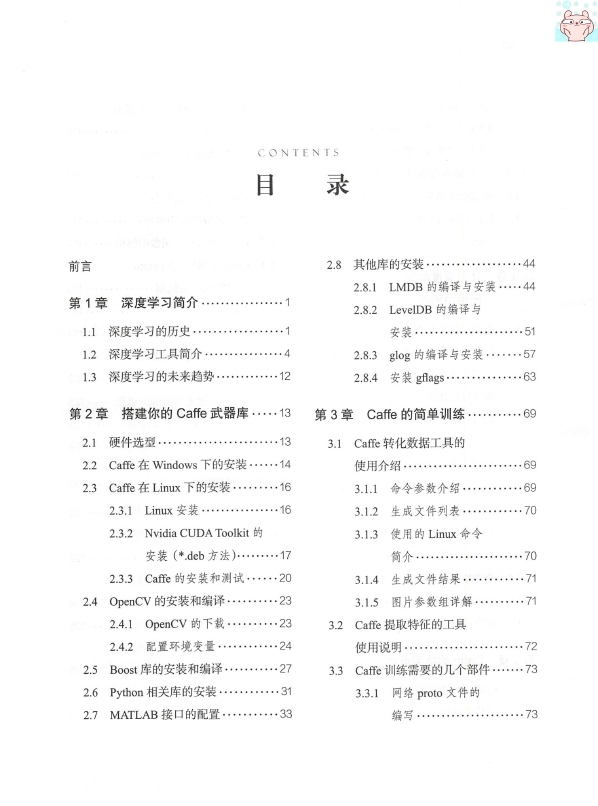

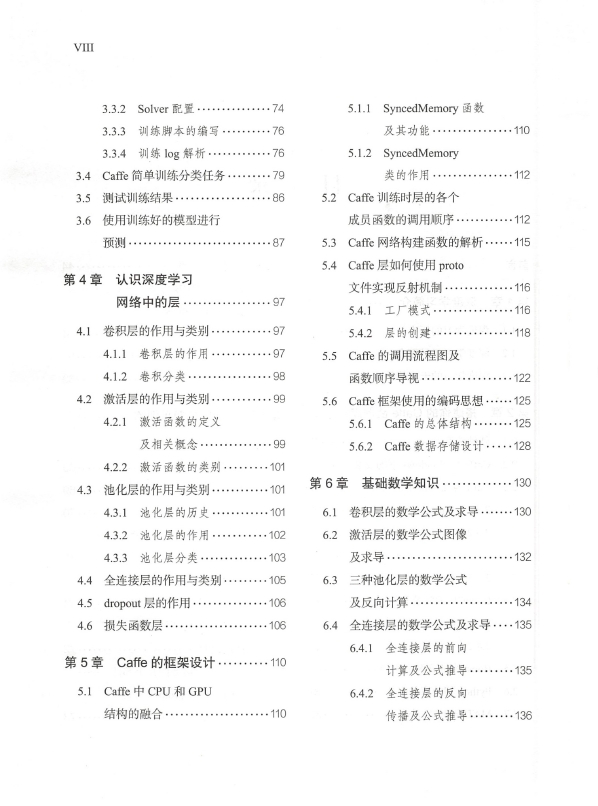

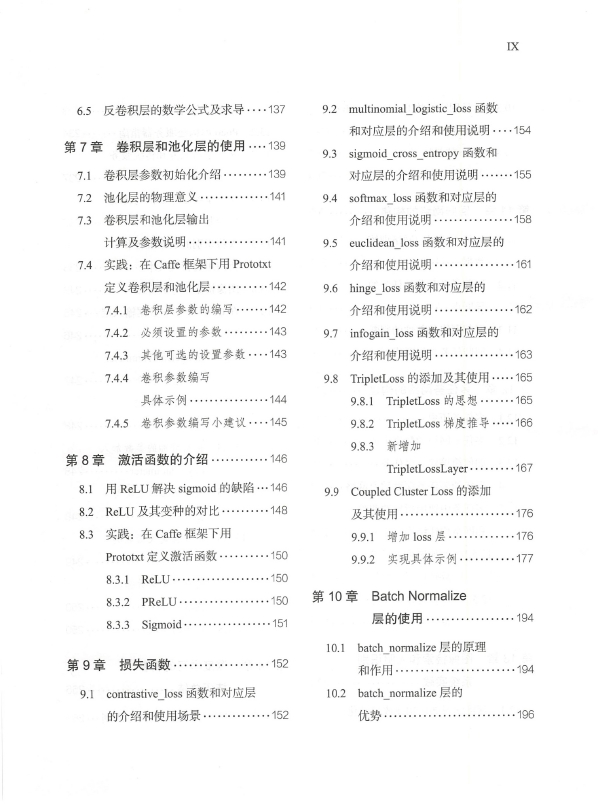

《深度学习实践-基于Caffe的解析》_薛云峰_2018-10-17_1

《深度学习实践-基于Caffe的解析》_薛云峰_2018-10-17_2

《深度学习实践-基于Caffe的解析》_薛云峰_2018-10-17_3

内容简介:

3.32 Solver配置

33.3训练脚本的编写

及其功能

3.34训练log解析

5.1.2 SyncedMemory

34Cae简单训练分类任务

类的作用

5测试训练结果

52Cae训练时层的各个

3.6使用训练好的模型进行

成员函数的调用顺序

预测

53Cae网络构建函数的解析

54cafe层如何使用 proto

第4章认识深度学习

文件实现反射机制

网络中的层

4.1工厂模式

4.1卷积层的作用与类别

54.2层的创建

4.1.1卷积层的作用

5.5 Caffe的调用流程图及

41.2卷积分类

函数顺序导视

4.2激活层的作用与类别

56 Caffe框架使用的编码思想……125

4,2.1激活函数的定义

56.1 Caffe的总体结构

及相关概念

56.2Cafe数据存储设计……128

4.2.2激活函数的类别

43池化层的作用与类别

第6章基础数学知识

43.1池化层的历史

⑩0

6.1卷积层的数学公式及求导

4.3.2池化层的作用

62激活层的数学公式图像

4.3.3池化层分类

44全连接层的作用与类别

4.5 dropout层的作用

及反向计算

4.6损失函数层

64全连接层的数学公式及求导……135

64.1全连接层的前向

5章 Caffe的框架设计

计算及公式推导

5.Cae中CPU和GPU

64.2全连接层的反向

结构的融合

传播及公式推导

65反卷积层的数学公式及求导…1379.2 multinomial logistic loss函数

和对应层的介绍和使用说明…154

第7章卷积层和池化层的使用…13993sgm0 d cross entropy I函数和

71卷积层参数初始化介绍

对应层的介绍和使用说明

72池化层的物理意义

9.4 softmax loss函数和对应层的

73卷积层和池化层输出

介绍和使用说明

计算及参数说明

9.5 euclidean loss函数和对应层的

74实践:在Cafe框架下用 Protox

介绍和使用说明

定义卷积层和池化层

9.6 hinge loss函数和对应层的

卷积层参数的编写

介绍和使用说明

42必须设置的参数

infogain loss函数和对应层的

743其他可选的设置参数……143

介绍和使用说明

744卷积参数编写

8 TripletLoss I的添加及其使用

具体示例

9.8.1 TripletLoss的思想

4.5卷积参数编写小建议…145

9.82 TripletLoss 2梯度推导…1

9.83新增加

第8章激活函数的介绍

TripletLossLayer

81用ReLU解决 sigmoid的缺陷…1

99 Coupled Cluster Loss的添加

8.2ReLU及其变种的对比

及其使用

83实践:在Caf框架下用

9.9.1增加loss层

Prototxt定义激活函数

992实现具体示例

8.3.1 ReLU

8.3.2 PReLU

第10章 Batch Normalize

8.3.3 Sigmoid

层的使用

10.1 batch normalize层的原理

第9章损失函数

9.1 contrastive loss函数和对应层

10.2 batch normalize层的

的介绍和使用场景

10.3常见网络结构 batch normalize

务,在_内.存_中做测试

层的位置

3.2Poco库构建服.务.器指南

104 proto的具体写法

3.3深度学习服务和传统服务

0.5其他归一化层的介绍

的区别

134深度学习服务如何与传统

第11章

后台服务进行交互

11如何生成回归网络训练

13.5人脸识别的数据准备和

数据

所使用的相关技术

112回归任务和分类任务的

13.6图像检索任务的介绍

异同点

13.7在Cafe中添加数据输入层…245

1.3回归网络收敛性的判断

13.7.1具体示例

14回归任务与级联模型

13.7.2 ImageDataParameter

参数舍义简介

第12章多任务网络的构建

3.7.3新增加参数的

12.1多任务历史

舍义筒介

248

2多任务网络的数据生成

4将新增加的参数加入

12.3如何简单建立多任务

24近年的多任务深度学习网络……2

13.7.5代码的编写之必写

2.5多任务中通用指导性调参

和网络构建结论

3.7.6用户自定义函数的

2.5.1如何避免出现多任务

性能下降的情况

3.7.7用户自定义数据的

2.52怎样构建性能提升的

多任务网络

13.7.8代码的实现

第13章图像检索和人脸识别

第14章深度学习的调参

系统实践

技巧总结

习如何构建成自动化

41不变数据的调参的基本原则…265

XI

42 Caffe fine-tuning调参的

结构概述

原则和方法

14.4

14.3综合数据调参的指导性

1442微软的 Residual Network

442012年以后的经典网络

结构

深度学习简介

1.1深度学习的历史

讲解深度学习,不得不提到人工神经网络,本书就先从神经网络的历史讲起,我们

首先来看一下第一代的神经网络

神经网络的思想最早起源于1943年的MCP人工神经元模型,当时是希望能够用计

算机来模拟人的神经元反应过程,该模型将神经元简化为三个过程:输入信号线性加权

求和、非线性激活(阈值法)。

第一次将MCP应用于机器学习(分类)的当属1958年 Rosenblatt发明的感知器

( perceptron)算法。该算法使用MCP模型对输人的多维数据进行二分类,并且还能够使

用梯度下降法从训练样本中自动学习更新权值。1962年,感知器算法被证明为能够收敛

(数学上在一定的范围之内,可以达到一个稳定的状态,也就是多次运行总能得到差不多

的结果),理论与实践的效果引起了神经网络的第一次浪潮

然而到了1969年,美guo数学家及人工智能先驱 Minsky在其著作中证明了感知器算

法本质上是一种线性模型,只能处理线性分类问题,就连最简单的XOR(异或)问题都

无法正确分类。这相当于直接宣判了感知器算法的死刑,神经网络的研究也陷入了近20

|